近期,我院可视媒体计算与智能处理团队论文被中国计算机学会(CCF)推荐的A类国际人工智能学术会议AAAI Conference on Artificial Intelligence(简称AAAI)2023接收,并于2月9日在计算机视觉专题会上进行相关成果汇报。AAAI 2023共收到 8777 份论文有效投稿,其中接收1721篇论文,录用率约为19.6%,接收论文中部分被选为Oral论文进行现场汇报。

Hierarchical Contrast for Unsupervised Skeleton-based Action Representation Learning

基于层级对比的无监督3D骨架动作表示学习

董建锋,孙圣凯,刘钟淋,陈书界,刘宝龙,王勋

浙江工商大学

论文链接:https://arxiv.org/abs/2212.02082

代码链接:https://github.com/HuiGuanLab/HiCo

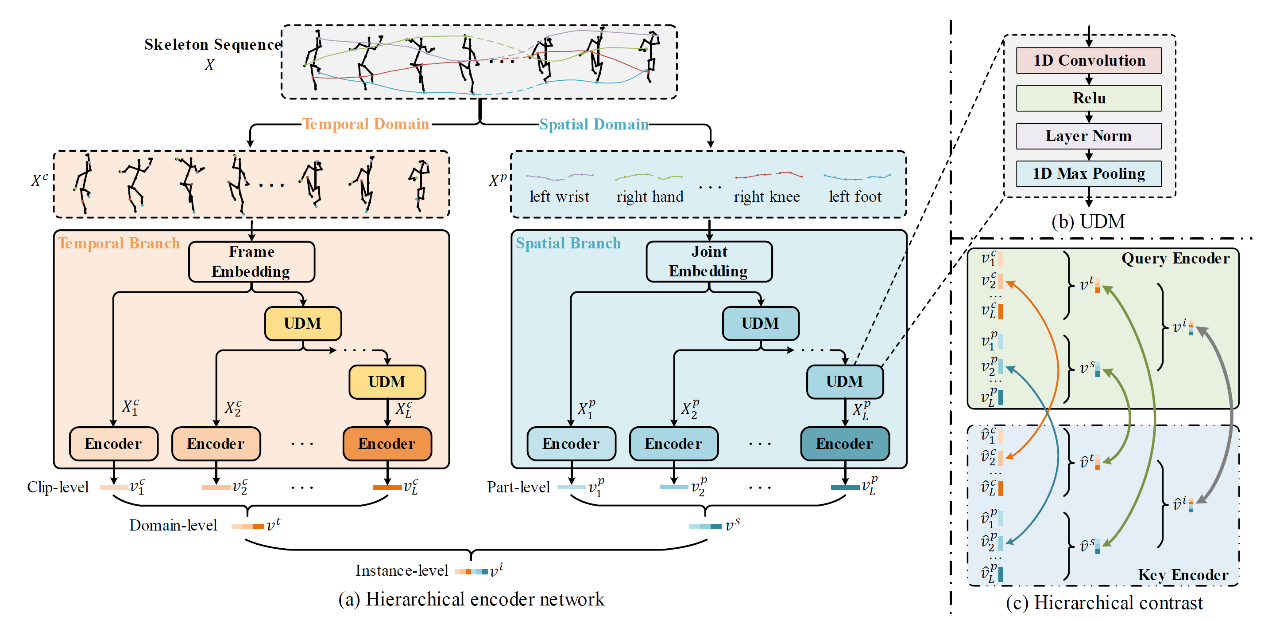

HiCo框架图

动作识别在人机交互、智能监控、视频内容分析、游戏控制等领域有着广泛的应用。近年来,基于3D骨架的动作识别取得了显著进展,然而大多数工作以完全监督的方式训练网络,这需要大量人工标注的骨架数据,花费昂贵且耗时。因此无监督的3D骨架动作表示学习方法也逐步受到了研究人员的关注。近年来机制简单、性能好的对比学习方法成为主流方法,这些基于对比学习的方法通常将3D骨架动作表示为实例级 (instance-level) 特征,然后进行实例间的整体对比。考虑到3D骨架动作具有层次结构的自然特征,这种表示对比方法可能是次优的。3D骨架动作作为序列,时间维度上可以看作帧 (frame) 的集合,空间维度上可以看作节点 (joint) 的集合。同时帧或节点是基本元素,可以构建为更大粒度的元素,如片段 (clip) 或部件 (part)。针对这一问题,课题组提出用于无监督3D骨架动作表示学习的层级对比框架HiCo。HiCo通过层级编码器网络将3D骨架动作序列编码为部件级 (part-level)、片段级 (clip-level)、域级 (domain-level)和实例级特征,并在这几个层次上分层地进行多级对比。这种层级对比与3D骨架动作的自然特点是一致的,并且提供了更多的监督信号,最终获得一个更好的动作特征表示。

可视媒体计算与智能处理团队简介

可视媒体计算与智能处理团队共15位教师,其中教授5名,研究员2名,副教授5名,讲师3名。团队负责人为王勋教授和董建锋研究员。团队师资力量雄厚,其中“国家百千万人才工程”入选者1名、国家级有突出贡献中青年专家1名,浙江省“万人计划”教学名师1名,浙江省新世纪“151人才工程”3名,浙江省“高校领军”人才1名。团队主要从事可视媒体大数据挖掘与智能分析、计算机视觉、模式识别和人工智能等相关领域的研究,在多摄像机协作跟踪、行人检测、车辆识别、视频检索、多模态理解、人体关键点检测和医学图像处理技术等方面有一定的研究积累。近三年,团队主持承担了国家支撑计划项目、国家(省部级)自然科学基金等项目20余项,累计到款1200余万元。团队成果丰富,在IEEE TPAMI,TKDE,TMM,TIP和ACM MM,CVPR,AAAI,IJCAI,SIGIR等国内外重要期刊与国际会议上发表高水平学术论文200余篇;相关研究成果获教育部科学技术二等奖1项,浙江省科学技术二等奖2项,三等奖1项,全国商业科技进步一等奖1项,二等奖2项。